如何降低无监督视频对象分割中的运动依赖性

Cho S, Lee M, Lee S, et al. Treating motion as option to reduce motion dependency in unsupervised video object segmentation[C]//Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. 2023: 5140-5149.

摘要

无监督视频对象分割(VOS)的目的是在像素级视频序列中检测最为显著的对象。在无监督视频对象分割中,大多数最先进的方法是利用外观线索和光流图中获得的运动线索来开发显著对象其独特的运动性质,相对背景而言。然而,运动线索在某些情况下是不可靠的,而这些方法对运动线索的过度依赖导致无法实现稳定的预测。为了减少现有的双向据流视频对象分割方法,我们提出了一种全新的运行选择网络,这种网络可以选择性地使用运动信息。此外,为了充分地利用所提出的网络的性质,即分割时并不总是需要运动的对象,我们引入了一种协作网络学习机制。在所有公共的基准数据集上,我们提出的网络提供了最先进的性能和实时的推理速度。代码参考

Ch01 介绍

视频对象分割(VOS)是一项基本的计算机视觉任务,其目的是在像素水平上检测给定视频序列中的对象。由于它在现实应用(如:机器人、视频编辑和自动驾驶)中具有很强的实用性,因此被广泛的应用到许多视觉系统中。基于对象分割引导方式,VOS可以分为许多子类别,例如:半监督VOS(初始掩膜引导)、无监督VOS(无引导)、弱监督VOS(初始包围盒引导)、交互式VOS(人工引导)和强化VOS(语言引导)。本研究关注主动非监督VOS,也称为零样本VOS,操作过程中没有为被分割的目标对象提供手动标注。由于没有提供关于该对象的明确引导,其目的是自动地定义给定视频序列中的显著对象,并且在全部帧中保持该对象分割的一致性。

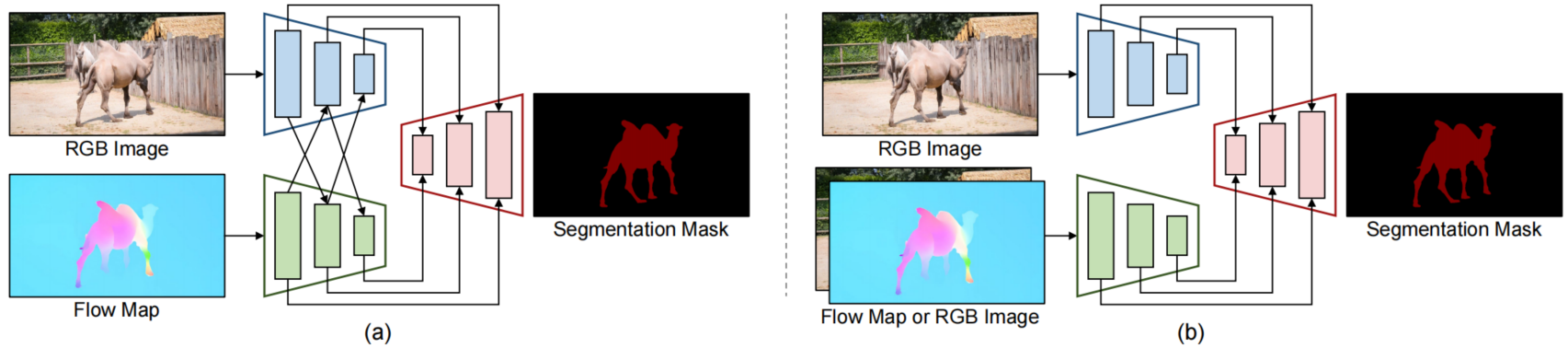

图1. 可视化比较 (a)卷积双流VOS网络、(b) 我们提出的卷积即选择网络

通常一个显著的物体与背景相比通常具有独特的运动,因此最近的无监督VOS方法利用从光流图中获得的运动线索和从RGB图像中获得的外观线索。在特征嵌入过程中将外观线索和运动线索融合起来提供相互引导(参见图1a)。MATNet[^41]构造了一个深度交错编码器架构用于对象外观和运动之间的层级交互。FSNet[^7]构造了一个关联式的交叉注意模块用于相互校正与双向交互。此外,AMC-Net[^35]拥有一个多模态协同注意力门将跨模态特征融合到统一的特征表示中。虽然这些方法获得了非凡的性能,但是它们容易受到低质量光流图的影响 ,因为光流图强烈地依赖于运动线索。

为了克服这个问题,我们设计了一个新的网络,这个网络可以不考虑运动的有效性就能够运行,我们称之为运动即选择网络(参见图1b)。提出的网络基于简单的编码器-解码器架构。编码器从运动中提取光流图,从RGB图像中提取语义特征,而解码器通过融合和解码的这些特征生成对象分割掩膜。与现有的双流VOS(如:MATNet、FSNet、AMC-Net)相比,我们分别编码各自的线索,然后在特征编码过程后通过相加完成融合。本质就是,运动流是自适应地打开或者关闭,从而保证网络较可能少地依赖于运动线索。如果运动流打开,运动线索被添加到外观线索上去构造最终线索,而如果关闭,则仅有外观线索被用于构造最终线索(RGB图像被用作运动编码器的输入)。与现有的双流方法相比,提出的运动即选择网络有两个主要优点:⑴因为网络在学习过程中仅将运动作为一个选项,因此在低质量光流中保证了稳健性;⑵在推理过程中,没有光流图也能运动,大大提高了其适应性和可用性。

为了充分地利用提出的”运动即选择“网络的性质,我们也提出了一种协作网络学习策略。由于在所提出的网络中可以选择是否采用运动线索,因此在训练阶段都需要提供有或者没有光流图的训练样本,以满足我们的网络设计目标。获得这些训练样本的一种直接方法是随机地丢弃VOS训练样本中的光流图。然而,为了更好地利用可选择地使用光流图这个特长,我们还采用了显著对象检测(Salient Object Detection,SOD)类的训练样本来提供大规模数据。当运动流被打开时,使用VOS训练样本,并且将光流图输入到运动编码器作为输入。当运动流被关闭时,使用SOD训练样本,并且将RGB图像被输入到运动编码器作为输入。

我们在无监督VOS的公共基准数据集(DAVIS-2016验证集、FBMS测试集、YouTube-Objects数据集)上验证了我们提出的方法,并且定量或者定性地与其他最先进的方法进行比较。在所有的基准数据集上,我们提出的方法都优于现有的方法,同时在一个GeForce RTX 2080 Ti GPU上保持了 40+ fps 的异常快速的推理速度。我们相信简单、快速、强大的解决方案是朝着高效和适用的VOS迈出的有意义的一步,并且可以为未来的研究提供坚实的基线。

我们的主要贡献总结如下:

- 我们引入了一种新的运动作为选择网络,可以选择是否利用运动线索和协作网络学习策略来最大化提出网络的优势。

- 所提出的”运动即选择“网络对低质量的光流图,甚至在没有光流图的情况下,也能表现良好。

- 在公共基准数据集上,提出的网络获得了最先进的性能,

- 与其他最近设计出的复杂网络架构相比,我们的方法只用了一个简单的编码器-解码器架构,使得实时推理速度达到 40+ fps。

Ch02 相关工作

2.1 时间一致性

视频的一个关键特性是:同一视频序列的不同帧共享彼此之间高度相关的相似内容。在无监督的VOS中,一些方法利用了视频的这种局部性,即观察到显著物体出现在视频的每一帧。COSNet[^17]从一个整体的视角强调了视频帧之间的内在相关性。它采用了一种全局的共同注意力机制来捕捉视频中经常重现的显著对象。AGNN[^30]通过将每一帧作为节点、帧之间的关系作为边,解决显著对象重现问题。通过在帧上迭代融合信息,可以获得对视频内容的完整理解。DFNet[^40]通过全局的角度学习判别性表示,获得了视频不同帧之间固有的长距离关系。AD-Net[^36]和F2Net[^16]通过建立参考帧和查询帧的像素嵌入之间的稠密对应关系,来重新考虑视频中的长距离时间依赖关系。由于这些方法需要多个帧来计算一致性,视频中的单独一个帧无法实现独立推理。

2.2 运动信息

为了利用显著对象所具有的可以与背景区分的独特运动的特性,一些方法利用了从预训练光流估计模型中获得的短期运动信息。MATNet[^41]是第一个引入双流编码器,这个编码器使用RGB图像和光流图来分别处理外观线索和运动线索。RTNet[^23]关注的是运动信息有时存在噪声太多的问题,这个问题导致了对象的误导。为了解决这个问题,我们提出了一个相互变换网络来关联帧内对比度、运动线索和重现对象的时间一致性。FSNet[^7]引入了一种全双工策略,以便更好地在外观线索和运动线索之间交换有用的信息。它包括了一个关系交叉注意力模块以实现跨嵌入子空间的双向信息传播。TransportNet[^38]通过使用了Sinkhorn层的最优结构匹配,在抑制干扰噪声的同时,建立了外观线索和运动线索之间的对应关系。AMC-Net[^35]调节外观特征和运动特征的权重,并且通过评估每个模态的重要性来抑制冗余信息和误导信息。因为在双流方法中每一帧都被单独处理,因此只需要一个RGB图像和一个光流图就可以推断视频中的一帧。然而,由于它们高度依赖于光流图的质量(容易受到低质量光流图的影响),因此无法实现稳定的和可靠的预测。

2.3 网络学习策略

与其他视觉任务相比,由于无监督VOS的训练数据量不足,现有的方法采用了多种网络学习策略来进行有效的网络训练。AGS[^31]利用了两个图像SOD数据集(DUT[^34]和PASCAL-S[^14]),这两个数据集都提供了静态注视数据和分割标注作为外部数据使用。COSNet和AGNN使用使用了预训练分割模型,这些分割模型是由MSRA10K[62]和DUT数据集训练完成,在DAVIS-2016数据集上进行了精调。在视频的主训练之前先在DUTS的外观流上预训练了网络。IMP[^13]采用了在大数据集(COCO[^15]和YouTube-VOS 2018[^33])上预训练的半监督VOS模型。

Ch03 具体方法

3.1 问题定义

无监督VOS的目标是使用输入的RGB图像$I:={I^0,I^1,\dots,I^{L-1}}$预测二进制分割掩膜$O:={O^0,O^1,\dots,O^{L-1}}$,其中$L$是给定视频序列的长度。为了利用运动和外观信息,使用预训练的光流模型生成光流图$F:={F^0,F^1,\dots,F^{L-1}}$,再将之作为输入用于2-通道运动向量到3-通道RGB值变换中。根据现有的双流VOS方法(如:MATNet[^41]、FSNet[^7]、AMC-Net[^35]),我们的方法对输入的视频进行逐帧处理,因此仅需要$I^i,F^i$就可以推断$O^i$。

3.2 运动即选择网络

为了减少现有的双流方法对低质量光流图的运动依赖性,我们提出了一种新的动作即选择网络,它可以灵活地利用运动线索来减少运动依赖性(详见图2)。

3.2.1 独立的编码器

考虑到外观线索与运动线索所拥有的不同的优势及互补性,现有的双流方法采用了强连接的编码器。在整个编码器的每个编码块后面,外观特征与运动特征交换着对方的信息。因为外观编码器与运动编码器无法分离,所以将它们看作一个独立的编码器。因为现有的双流VOS方法非常依赖于从光流图中提取的运动线索,因此当使用低质量的光流图作为输入时会导致关键性错误。

与现有的双流方法不同,我们使用两个独立的编码器分别嵌入外观特征和运动特征。定义外观特征为${A_k}{k=1}^K$,定义运动特征为${M_k}{k=1}^K$,其中$K$为编码器的编码块数,更高的$k$值表示更高级别的特征。外观特征从RGB图像中提取出来,而运动特征从其他RGB图像或者光流图中得到。在混合外观特征和运动特征后,融合特征${X_k}_{k=1}^K$定义为:

$$

X_k=A_k+M_k

$$

因为外观特征和运动特征是分别嵌入再融合的,所以很容易分别获取外观线索和运动线索。这使得我们的网络对运动流信息的依赖越来越少,因此在面对不准确的运动线索时具有稳健性。此外,在网络训练过程中同时使用RGB图像和光流图作为运动编码器的输入,可以防止网络对显性运动线索的过拟合。

3.2.2 解码器

解码器对融合的特征进行细化,再生成二进制分割掩膜。为了产生高分辨率掩膜,融合的特征使用类似于TBD[^4]的解码块进行细化。每个解码块包括:一个混合不同特征的卷积层、一个强化信道与空间特征表示的CBAM层[^32]和一个增加特征的空间大小的上采样层。假设$\Psi_k$表示第$k$个解码块,其中更高的$k$值表示更高级别的特征,于是解码特征${D_k}{k=1}^K$的公式如下:

$$

D_k=\begin{cases}

\Psi_k(X{K-k+1})&k=1\

\Psi_k(D_{k-1}\oplus X_{K-k+1})&otherwise

\end{cases}\tag{2}

$$

其中,$\oplus$表示通道拼接。在$K$个解码块后,使用 argmax 算子进行值量化,然后可以定义最终分割掩膜$O$。第一个与第二个通道分别表示背景分割图和前景分割图。

3.3 协同学习策略

提出的运动即选择网络的关系性质是选择性地利用光流图。为了实现我们的网络设计目标,训练网络时需要两类训练样本(有光流图、无光流图)。实现这一目标的简单方法是有意地和随机地丢弃VOS训练样本的光流图。然而,我们采用的是SOD训练样本来代替前面的方法,这样就能充分利用所提出的网络优势(即光流图不是必须的)。当采用VOS样本时,使用光流图作为运动编码器的输入,而采用SOD样本时,使用RGB图像作为运动编码器的输入。

虽然以协同的方式提供训练样本看起来很合理,因为这样的方式能够最大限度地提升建议网络的有效性,但是由于VOS和SOD数据格式的不同,这样的方式不能简单地在GPU设备上实现。因为批训练可以加速网络训练,因此为了满足批训练的需要,并且保证训练过程的稳定性,我们使用了一个简单的索引技巧。首先,从VOS和SOD组成的数据集中生成训练数据样本。每个VOS训练样本包括:一张RGB图像、一张光流图和一张基准分割掩膜。每个SOD训练样本包括:一张RGB图像和一个张基准分割掩膜。然后,为了保证样本具有相同的格式,还会生成一个空的张量,并且将这个张量作为SOD样本的光流图。为了验证光流图的有效性,每个训练样本会分配一个运动效度索引,并且分别为VOS样本和SOD样本分配$1$和$0$。使用生成的索引,特征融合过程如代码清单1所示。

1 | # A: 外观特征 |

代码清单1:用于批训练的特征融合过程

3.4 实现细节

3.4.1 光流图

为了利用运动信息和外观信息,我们从光流图中提取语义运动线索。为了生成第$i$帧的光流图,我们将第$i$帧作为起始帧,将第$i+1$作为目标帧。如果第$i$帧为最视频的最后一帧,则第$i-1$帧为目标帧。关于光流估计网络,我们使用Sintel[^1]数据集上的RAFT[^28]作为预训练模型。光流图的生成不改变 VOS数据样本的原始分辨率。为了减少冗余训练和测试时间,我们提前生成了光流图,而不是在推理过程中实时计算。

3.4.2 编码器

遵循大多数现有的无监督VOS方法(如:COSNet[^17]、AD-Net[^36]和MAT-Net[^41]),我们使用ResNet-101[^5]作为骨干编码器。其由四个区块组成,即$K=4$。从第$k$个区块中提取的特征的尺度为原始分辨率的$1/2^{k+1}$倍。为了保存从大量的训练样本中学习到的丰富的特征表示,我们使用了ImageNet[^12]预训练版本初始化外观和运动编码器。

3.5 网络训练

3.5.1 数据准备

为了获得训练数据的多样性,我们同时采用了VOS和SOD数据集,如(Sec3.3)所述。DAVIS-2016[^21]作为VOS训练数据集,而FBMS[^19]也有一个数据集,但是遵循公共协作在无监督VOS中没有作为数据集进行网络训练;DUTS[^29]作为SOD训练数据集,DUTS的训练数据集和测试数据集都被作为训练数据集使用。训练数据分别按照固定的概率$25%$和$75%$从VOS和SOD样本中随机地采样。

3.5.2 训练细节

在所有的训练阶段,我们将RGB图像、光流图和分割掩膜的尺寸都调整为$384\times384$分辨率。我们使用双边插值来调整RGB图像和光流图的尺寸,使用最近邻插值来调整分割掩膜的尺寸来保证值或者为0或者为1。对于网络优化,我们使用交叉Adam优化器[^10],其学习率设置为$1e-5$,不带学习率衰减;批处理大小设置为$16$。参照现有的半监督VOS算法 ,如:STM[^20]、KMN[^25]、CFBI[^37]和BMVOS[^3],我们在训练过程中冻结了所有批处理归一化层[^6]。网络训练在两个GeForce RTX 2080Ti GPU上实现,使用时间不到20个小时。

Ch04 实验结果

Ch05 结论

在无监督VOS中,外观流和运动流的协同使用已经是一个有效的和强大的工具。然而,现有的双流方法在早期融合了外观线索和运动线索,因此它们非常依赖于运动线索。这使得它们容易受到低质量光流图的影响,降低了它们的可用性和可靠性。为了缓解这个忧虑,我们提出了一种协作网络学习策略,在所有的公共基准测试数据集上,我们的提供他一种全新的、具有实时推理速度的最优性能。我们相信这种简单、快速和强大的方法可以为未来的VOS研究提供坚实的基线。